ASCII E UNICODE

Uma codificação de caracteres é um padrão de relacionamento entre um conjunto de caracteres com um conjunto de outra coisa, como por exemplo números ou pulsos elétricos com o objetivo de facilitar o armazenamento de texto em computadores e a sua transmissão através de redes de telecomunicação.

Exemplos comuns, ou seja, algumas das formas de representação são:

-ASCII;

ASCII é uma sigla para “American Standard Code for Information Interchange” (Código Padrão Norte-americado para Intercâmbio de Informações). Esse código foi proposto por Robert W. Bemer, visando padronizar os códigos para caracteres alfa-numéricos (letras, sinais, números e acentos). Assim seria possível que computadores de diferentes fabricantes conseguissem entender os códigos.

O ASCII é um código numérico que representa os caracteres, usando uma escala decimal de 0 a 127. Esses números decimais são então convertidos pelo computador para binários e ele processa o comando. Sendo assim, cada uma das letras que você digitar vai corresponder a um desses códigos.

Unicode é um padrão adotado mundialmente que possibilita com que todos os caracteres de todas as linguagens escritas utilizadas no planeta possam ser representados em computadores.

No site http://www.network-science.de/ascii/ é possível utilizar a ferramenta “ASCII Generation”.

Exemplos comuns, ou seja, algumas das formas de representação são:

-ASCII;

-Unicode (É um padrão que permite aos computadores representar e manipular, de forma consistente, texto de qualquer sistema de escrita existente);

-EBCDIC (Utilizado em servidores IBM antigos, é completamente diferente do ASCII);

-IBM PC Extended Character (Caracteres representados por binários desde 128 até 255 (0… 127: ASCII). Representações de dígitos da representação Unicode);

-ISO Latin and ANSI (Partilham os primeiros 255 caracteres. A partir deste número os formatos diferem do Unicode).

O ASCII é um código numérico que representa os caracteres, usando uma escala decimal de 0 a 127. Esses números decimais são então convertidos pelo computador para binários e ele processa o comando. Sendo assim, cada uma das letras que você digitar vai corresponder a um desses códigos.

Unicode é um padrão adotado mundialmente que possibilita com que todos os caracteres de todas as linguagens escritas utilizadas no planeta possam ser representados em computadores.

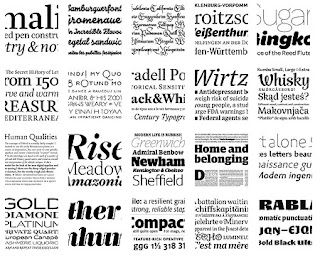

O padrão Unicode é capaz de representar não somente as letras utilizadas pelas linguagens mais “familiares” para nós ocidentais, como Inglês, Espanhol, Francês e o nosso Português, mas também letras e símbolos utilizados em qualquer outra linguagem: Russo, Japonês, Chinês, Hebreu, etc. Além disso, inclui símbolos de pontuação, símbolos técnicos e outros caracteres que podem ser utilizados em texto escrito.

_______ __ .______ ___ ______

/ _____|| | | _ \ / \ / __ \

| | __ | | | |_) | / ^ \ | | | |

| | |_ | | | | / / /_\ \ | | | |

| |__| | | | | |\ \----./ _____ \ | `--' |

\______| |__| | _| `._____/__/ \__\ \______/

No site http://www.network-science.de/ascii/ é possível utilizar a ferramenta “ASCII Generation”.

kingraçado

ResponderEliminar